NCE编辑优选:基于人工智能算法的忆阻器行为预测模型

文章介绍

Yibei Zhang(张伊蓓), Qingtian Zhang(张清天), Qi Qin(秦琦), Wenbin Zhang(张文彬), Yue Xi(席悦), Zhixing Jiang(江之行), Jianshi Tang(唐建石), Bin Gao(高滨), He Qian(钱鹤) and Huaqiang Wu(吴华强)

通讯作者:

- 张清天,清华大学

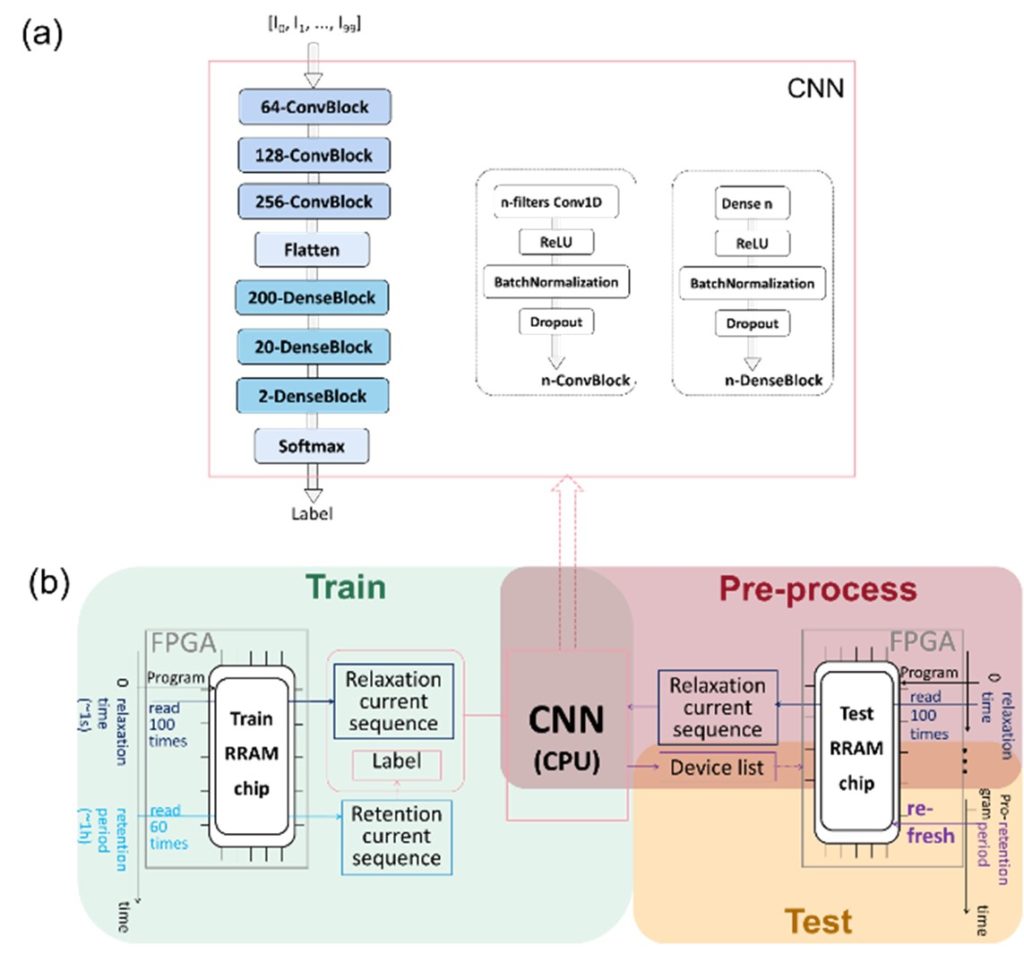

实验采用两片具有多层感知机(MLP)网络架构的RRAM存算一体芯片来表征RRAM器件的保持行为以及对推理精度的影响,分别用于获取网络训练数据以及功能测试。预测模型中采用基于CNN的结构,每个器件取其编程后短时间内的电流变化表示弛豫行为,由模型输出其保持特性是否足够优秀。系统根据预测结果在一段时间后对器件进行选择性刷新。其中模型预测准确率可达90%以上。

图1 基于CNN的预测模型结构及工作过程

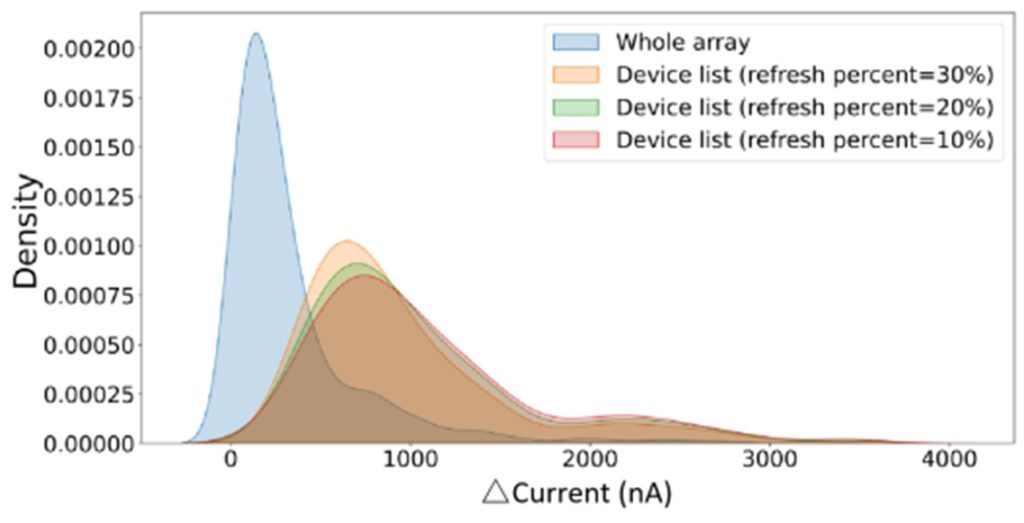

图2 全阵列与预测待刷新器件的漂移电流分布

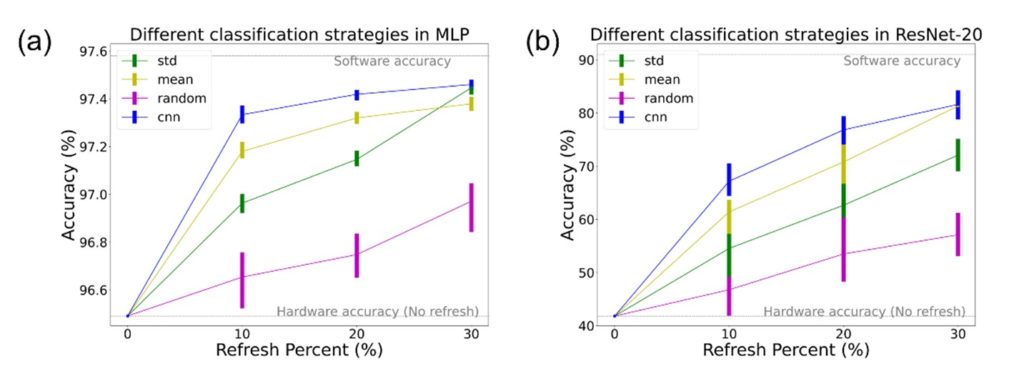

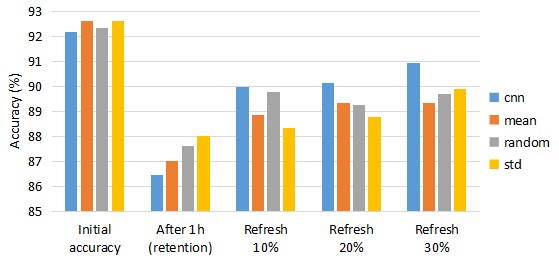

将待刷新器件阻值替换为标准值,并代入基于MLP,RESNET-20网络的图像识别任务的网络模型后,均可观察到精度的明显提升。该提升比例随刷新周期缩短,替换比例增大而增大,且优于同等条件下基于随机采样、平均值、标准差等统计数据进行预测的模型,证明了该模型的合理性以及出色的精度恢复效果。

图3 仿真任务中基于CNN的预测模型精度恢复效果及与统计模型的比较

硬件实现方面,在编程一小时后对芯片进行选择性刷新,可使芯片恢复约60%~80%的精度损失。在功耗方面,选择性刷新策略所节省的大规模阵列读操作以及部分器件的编程操作,可使得阵列刷新时间减少至原时间的20%~55%。

图4 硬件推理中基于CNN的预测模型精度恢复效果及与统计模型的比较

研究背景:

RRAM因其高密度存储以及存内计算的能力而被广泛应用于AI算法相关的矩阵向量乘积任务中,然而RRAM自身的弛豫特性、保持特性等非理想特性对系统的性能造成了很大影响。已有的器件优化方法大多从机理、仿真模型等方向出发,试图使用共性结论对器件进行优化,而缺少对单个器件差异性的关注;而片上训练,步进式脉冲编程策略等能够适应器件差异性的优化方法又需要消耗大量的时间及功耗。因此,本文试图借助人工智能算法对器件进行性能评估,并根据评估结果进行阵列选择性刷新,在更低的能量延时开销下,实现与逐个器件适应性操作所接近的精度,同时展示之前被当作不同特性的RRAM弛豫、保持特性间也可能存在一定的联系。

作者介绍

张清天 助理研究员

清华大学

- 张清天博士是清华大学的助理研究员,属于集成电路学院钱鹤、吴华强团队,同时担任北京未来芯片高精尖创新中心的算法部主任,研究兴趣为面向存算一体以及神经形态计算的深度学习算法,先后在《自然》(Nature)、《自然纳米技术》(Nature Nanotechnology)等顶级期刊以及国际电子器件会议(IEDM)等领域内顶级国际学术会议上发表多篇论文。

期刊介绍

- Neuromorphic Computing and Engineering(NCE)是一本涵盖多个学科领域、采用开放获取(OA)形式出版的期刊。NCE期刊将神经形态系统的硬件和计算方面结合在一起,读者群覆盖工程、材料科学、物理、化学、生物学、神经科学和计算机科学等领域,跨越学术界和产业界的各个群体。在NCE期刊上发表的研究需针对神经形态系统和人工神经网络领域做出及时而重要的贡献。